・機械学習ベースの新しい知覚フレームワークを使って、90種類以上の物体を触覚で認識できるようになります。

・視覚と触覚の両方を用いて、これらの観察が同じ対象物に対応しているかどうかを識別します。

人間は、複数のモダリティを使って、物体の外観や物性を連想することが得意です。ハサミを見れば、金属の表面に触れる指の感触を想像し、その識別だけでなく、大きさ、形、比率など、頭の中でイメージすることができます。

一方、ロボットの知覚は、本来マルチモーダルではありません。高度なカメラを搭載した既存のロボットは、2つの異なる物体を区別することができますが、視覚だけでは不十分なことが多く、特に閉塞された空間や光の条件が悪い場合には区別できなくなります。

今回、カリフォルニア大学バークレー校の研究者は、ロボットマニピュレーターに人間のようなマルチモーダルな関連付けを学習させる方法を開発しました。これは、視覚と触覚の両方を用いて、これらが同じ物体に対応しているかどうかを調べるものです。

これまでどうしてきたか?

研究チームは、ロボットの指に装着された2つのGelSightセンサーによる高解像度タッチセンシングと、マルチモーダル関連付けのための畳み込みニューラルネットワーク(CNN)を採用しました。

このセンサーは、エラストマーゲルと一体化したカメラで読み取りを行い、物体との接触で生じるゲルのくぼみを記録します。この測定値をCNNに送り、データ処理を行います。

研究者たちは、センサーからの触覚とカメラからの物体画像を取り込み、これらの入力が同じ物体を表しているかどうかを識別するために、これらのCNNを訓練しました。インスタンス認識を行うために、ロボットの触覚とクエリ対象物の視覚的な観察を組み合わせました。

彼らは、NVIDIA GeForce GTX 1080とTITAN X GPUとCUDA深層学習フレームワークを用いて、33,000枚以上の画像に対してマルチモーダル関連付けのためのCNNをトレーニングおよびテストしました。

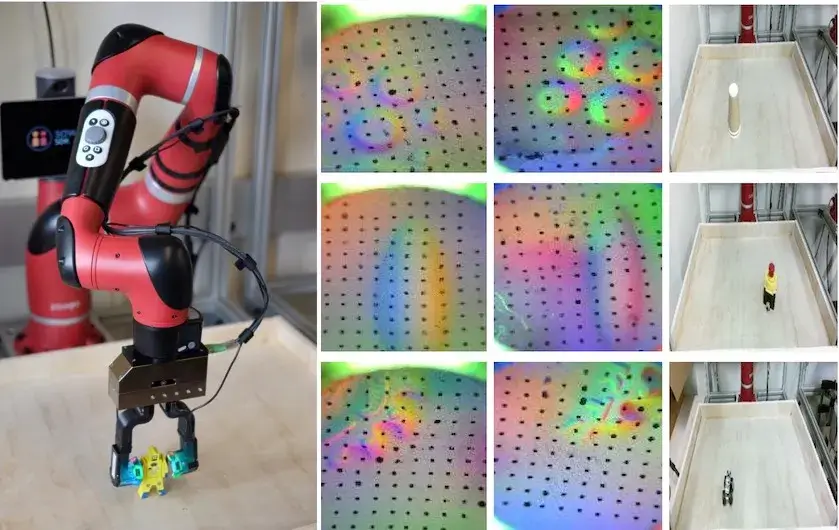

2つのGelSight触覚センサー(各指に1つずつ)と正面RGBカメラで構成されたロボット(左)|

触覚観察の例(中)と1つの物体に対応する物体画像(右) | 研究者からの提供

この結果は、トレーニングで一度も使われなかったインスタンスも含め、触覚の読み取りだけでオブジェクトのインスタンスを認識することが可能であることを実証しています。実際、CNNは一部の人間のボランティアや代替手段を凌駕していました。

今後はどうなる?

これまで、研究者はそれぞれの感覚を個別に考えてきました。次の研究では、複数の触覚インタラクションを使用して、クエリーオブジェクトのより完全な画像を取得する予定です。

さらに研究チームは、ロボットが商品画像を見て、棚にある物を感じて取り出すロボット倉庫にこのシステムを導入することも計画しています。また、この新しい手法は、家庭環境におけるロボットにも応用でき、手の届きにくい場所にある物を取り出させることができます。