・Dactylは、人の手を借りなくても、シミュレーションだけで物体の向きを変えることができます。

・指先の座標と従来のRGBカメラ3台の画像を解析できます。

・物理エンジンMuJoCoを使って、ダンピングや摩擦といった物理的特性を測定します。

人は、日常的に物体を操作していますが、自律的な機械にとっては難しい動きです。今日の先進的なロボットは、制約のある環境の中で特定のタスクをするために設計されており、複雑なエンドエフェクターを使いこなすことができません。

初めて人間の手が開発されてから10年以上が経ちますが、現実世界で物体を動かすのは、いまだに困難な課題のひとつになっています。

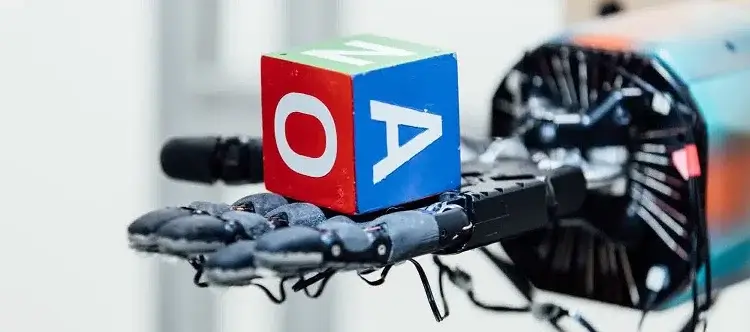

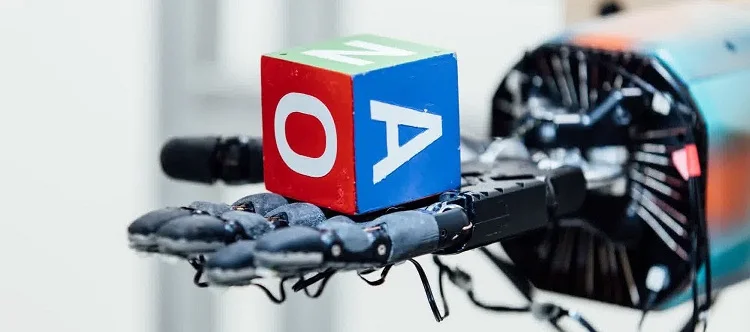

近年、OpenAIの研究者たちが、3D物体を異例の精密さで把持・操作できるディープラーニングシステム「Dactyl」を発表しました。このシステムは、人間が手出しすることなく、シミュレートされた環境で物体の向きを変えるタスクを解決できます。

研究者はロボットの手のひらに物体(三角柱や ブロック)を置き、その物体をさまざまな向きに再配置するようロボットに指示しました。Dactylは、指先の座標と従来のRGBカメラ3台からの画像を解析します。

しかし、このタスクは私たちが考えているほど単純ではありません。実世界でのノイズ、部分的な観測の操作、複数の次元の制御、複数の物体の操作など、多くの課題があります。

新しい試み

画像元: OpenAI

研究者たちは、より多くの人が使えるようにするため、もっとリアルに近づけるのではなく、ドメイン・ランダムライゼーションという新しいアプローチをシミュレーションしました。研究チームは、MuJoCo物理エンジンを使ってロボット工学のシミュレーション版を開発しました。このエンジンは、消音、摩擦、転がり抵抗などの物理的属性の測定ができます。

全てのダイナミクス・パラメータを推測することはできないので、Long Short Term Memoryネットワークを使用し、周囲のダイナミクスについてより多くの数値を集めました。また、OpenAI Fiveのために開発されたのと同じトレーニングコードとアルゴリズムを使用しましたが、システムアーキテクチャとハイパーパラメータは違うものです。

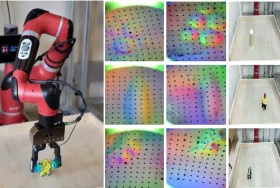

ポーズ推定器は畳み込みニューラルネットワークに記録され、ロボットハンドの近くに固定された3台のRGBカメラからビデオクリップを収集し、対象物の位置と向きを判定します。これらを正確に行うために、複数のカメラを使いました。

現状

ニューラルネットワークは、100年分相当のデータを、NVIDIA Tesla V100 GPUとCUDAディープラーニングフレームワークで加速されたTensorFlowを使用して、わずか50時間で処理しました。完全に訓練すると、物体(立方体)を落とすことなく50回の連続回転を行うことができました。

特定のタスクでは、人間が普段行っている手先の動きを使います。研究者たちは、自動でこのような動作ができることを発見しました。

Dactylは先端をつまむような細かい動作をする時、小指と親指を使いますが、私たち人間は同じ作業をするのに親指と中指または人差し指を使います。ロボットの小指に余分な自由度があるのが原因と考えられています。このことは、システムが自然につかめるようになり、持っている能力を限界まで使えるようになることを示しています。

この結果から、深層強化学習アルゴリズムが、学習していない実世界の問題を解決するために使用できることがわかります。研究者たちは、このアプローチがまだ完璧ではないことを認めていますが、より複雑なタスクを実行できるように改善することは可能だと言っています。